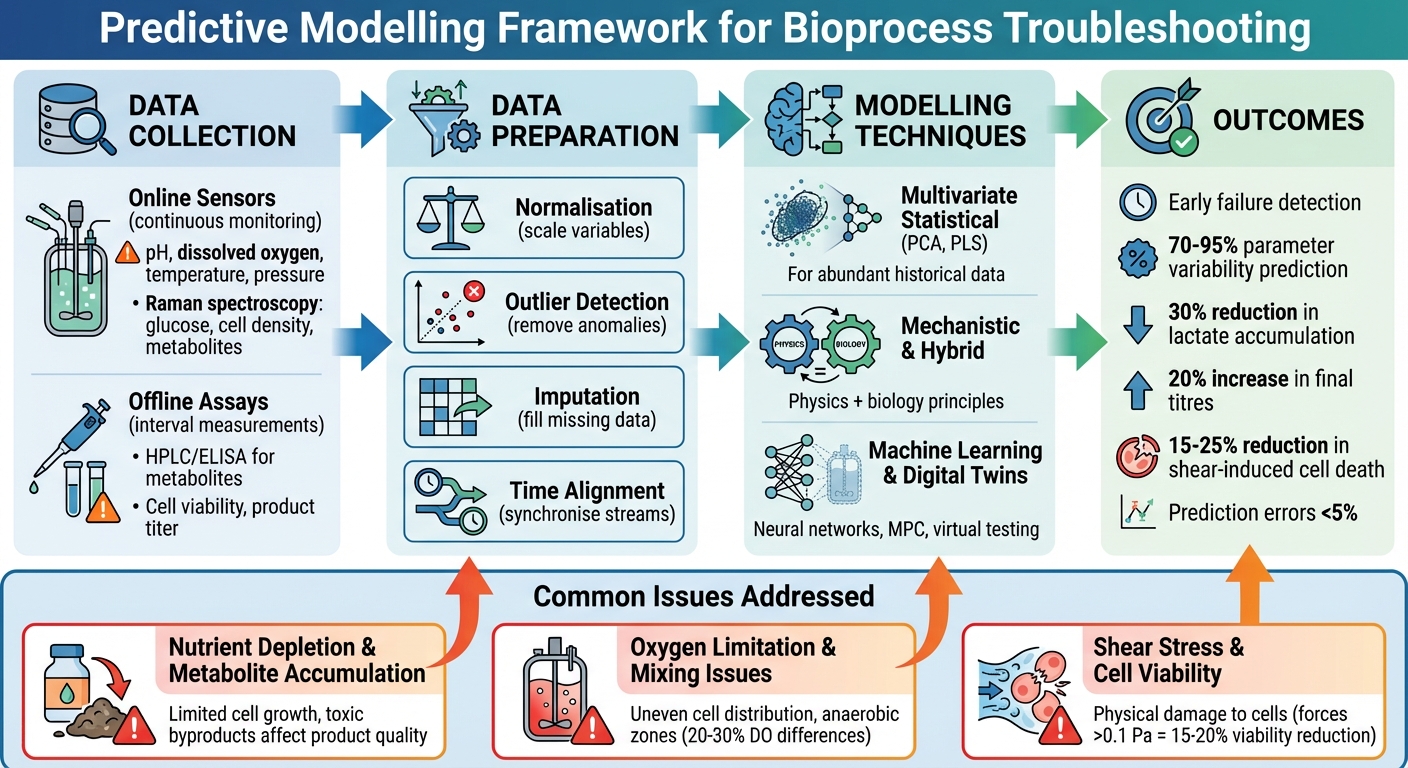

Prädiktive Modellierung transformiert die Produktion von kultiviertem Fleisch, indem sie Prozessprobleme identifiziert, bevor sie eskalieren. Durch die Analyse historischer und Echtzeitdaten helfen diese Modelle den Betreibern, optimale Bedingungen in Schlüsselphasen wie Zellwachstum, Differenzierung und Reifung aufrechtzuerhalten. Dieser proaktive Ansatz reduziert Ausfälle, verbessert die Erträge und gewährleistet eine gleichbleibende Produktqualität.

Wichtige Erkenntnisse:

- Phasen, die anfällig für Probleme sind: Nährstoffmangel, Sauerstoffmangel und Scherstress sind häufige Risiken.

- Modelltypen: Mechanistische, datengetriebene und hybride Modelle bieten maßgeschneiderte Lösungen zur Fehlerbehebung.

- Vorteile: Früherkennung von Ausfällen, präzise Ursachenanalyse und kontinuierliche Prozessoptimierung.

- Datenanforderungen: Hochwertige, vielfältige Datensätze von Online-Sensoren und Offline-Tests sind entscheidend.

- Techniken: Werkzeuge wie PCA, PLS und digitale Zwillinge verbessern Vorhersagen und Prozesskontrolle.

Prädiktive Modellierung ist eine datengesteuerte Lösung zur Bewältigung von Herausforderungen in der Produktion von kultiviertem Fleisch und bietet verbesserte Konsistenz und betriebliche Effizienz.

Prädiktives Modellierungsframework für die Fehlerbehebung im Bioprozess von kultiviertem Fleisch

200: Beherrschung der Qualität durch Design: Von Produktfehlern zum kommerziellen Erfolg in Biologics CMC De...

Datenanforderungen für prädiktive Modellierung

Die Erstellung genauer prädiktiver Modelle hängt von der Qualität und Bandbreite der Daten ab, die während des Bioprozesses gesammelt werden. Ohne detaillierte Datensätze ist es unmöglich, dass Modelle Ausfälle vorhersagen oder die Leistung verbessern. Es ist entscheidend, sowohl die physikalischen Bedingungen im Bioreaktor als auch das biologische Verhalten der Zellen zu erfassen.Diese Grundlage ist entscheidend für die effektive Vorbereitung von Daten und die Anwendung von Modellierungstechniken.

Datenquellen in kultivierten Fleisch-Bioprozessen

Prädiktive Modelle stützen sich auf zwei primäre Datenquellen: Online-Sensoren und Offline-Assays.

Online-Sensoren überwachen kontinuierlich Echtzeitparameter wie pH-Wert, gelösten Sauerstoff (DO), Temperatur und Druck. Einige fortschrittliche Plattformen, wie Sartorius ambr-Systeme, verwenden sogar Raman-Spektroskopie, um Glukosespiegel, lebensfähige Zelldichte und Metaboliten zu verfolgen [2][3]. Diese Sensoren liefern hochfrequente Daten und erfassen die kleinsten Veränderungen im Bioreaktor.

Offline-Assays hingegen liefern präzise Messungen in bestimmten Intervallen. Techniken wie HPLC oder ELISA werden verwendet, um Metabolitenkonzentrationen (z.B. Laktat und Ammoniak), Zellviabilität und Produkttiter zu bewerten.Während diese manuelle Probenahme und Laborarbeit erfordern, bieten sie ein Maß an Präzision, das Online-Sensoren möglicherweise nicht immer erreichen[2][3]. Metadaten, wie Fütterungsstrategien und Sollwerte, helfen bei der Interpretation von Sensordaten. Zum Beispiel ermöglicht die Kombination von Raman-Spektroskopiedaten mit Fütterungsprofilen multivariate Modelle, um kritische Qualitätsmerkmale wie den Endtiter vorherzusagen. Dies ermöglicht modellprädiktiven Kontrollsystemen, Echtzeitanpassungen an Bioprozessparametern vorzunehmen[2][3]. Solche Ansätze verbessern die Fähigkeit von Modellen, Probleme zu beheben und die Leistung zu optimieren.

Sobald die Daten gesammelt sind, müssen sie sorgfältig verarbeitet werden, um sicherzustellen, dass sie zuverlässige Vorhersagen treffen können.

Datenvorverarbeitungstechniken

Rohdaten aus Bioreaktoren sind selten bereit für den Einsatz in prädiktiven Modellen. Mehrere Vorverarbeitungsschritte sind notwendig, um es vorzubereiten:

- Normalisierung stellt sicher, dass Variablen auf vergleichbare Bereiche skaliert werden. Zum Beispiel verhindert es, dass Parameter wie Zelldichte (die oft größere Werte hat) kleinere Variablen wie pH überschattet. Dieser Schritt ist besonders wichtig für Algorithmen wie Partial Least Squares (PLS)[3] .

- Ausreißererkennung identifiziert und entfernt Anomalien, die durch Sensorrauschen, Stichprobenfehler oder vorübergehende Störungen verursacht werden. Statistische Schwellenwerte oder PLS-basierte Methoden werden häufig verwendet, um diese Ausreißer auszuschließen und zu verhindern, dass sie Vorhersagen verzerren[3] .

- Imputation füllt fehlende Datenpunkte aus. Techniken wie die Imputation durch Regression (IBR) nutzen Korrelationen zwischen Parametern - zum Beispiel Glukose- und Laktatwerte - um Lücken zu schätzen.Wenn DO-Daten fehlen, kann das Modell sie basierend auf den Beziehungen zwischen pH und Glukose vorhersagen, um die Zuverlässigkeit des Datensatzes für Echtzeitprognosen zu bewahren[3] .

- Zeitliche Ausrichtung synchronisiert Datenströme, die möglicherweise nicht natürlich übereinstimmen. Zum Beispiel müssen kontinuierliche pH-Messungen mit Metabolit-Assay-Ergebnissen abgeglichen werden, die in bestimmten Intervallen genommen werden. Methoden wie dynamische Zeitverzerrung oder lineare Interpolation werden verwendet, um eine ordnungsgemäße Ausrichtung sicherzustellen[3] .

Umgang mit biologischer Variabilität

Biologische Variabilität stellt eine der größten Herausforderungen in der Produktion von kultiviertem Fleisch dar. Unterschiede in Zelllinien, genetische Drift und unterschiedliche Reaktionen auf Nährstoffmangel führen zu Inkonsistenzen in Wachstumsraten und Metabolitprofilen von Charge zu Charge[2][4][6]. Diese Variabilität kann die Genauigkeit von Vorhersagen erheblich beeinflussen. Wenn ein Modell beispielsweise nicht darauf ausgelegt ist, Unterschiede zwischen Zelllinien oder Produktionsmaßstäben zu berücksichtigen, können Vorhersagen für die lebensfähige Zelldichte erheblich abweichen.

Um dies zu bewältigen, sollten Produzenten vielfältige historische Datensätze sammeln, die mehrere Zelllinien, Medienzusammensetzungen und Bioreaktorgrößen abdecken. Die multivariate statistische Prozesskontrolle (MSPC) kann helfen, indem sie die Variabilität in systematische und zufällige Komponenten aufteilt, sodass Modelle normale Schwankungen von tatsächlichen Problemen unterscheiden können[3] [4][6].

Eine weitere effektive Lösung ist die Verwendung von hybriden Modellen. Diese kombinieren mechanistisches Wissen - wie Monod-Kinetik für das Zellwachstum - mit datengetriebenen Methoden.Diese Mischung ermöglicht es Modellen, sowohl die vorhersehbaren biologischen Prozesse als auch die unvorhersehbaren Variationen zu erfassen, die rein mechanistische Modelle möglicherweise übersehen[3][4][6]. Darüber hinaus hilft die Verwendung von serumfreien Medien mit gut definierten, tierfreien Formulierungen, die Nährstoffzusammensetzungen zu standardisieren. Dies reduziert die Variabilität, was zu konsistenteren Daten und zuverlässigeren Vorhersagemodellen führt[1].

Modellierungstechniken zur Fehlerbehebung in Bioprozessen

Die Auswahl des richtigen Modellierungsansatzes hängt davon ab, wie gut der Prozess verstanden wird, von der Qualität der verfügbaren Daten und den spezifischen Fehlern, die Sie vorhersagen möchten. Jede Technik bringt ihre eigenen Stärken in die Fehlerbehebung von kultivierten Fleischbioprozessen ein und arbeitet harmonisch mit den vorherigen Schritten der Datenvorbereitung zusammen.

Multivariate statistische Modelle

Wenn historische Daten reichlich vorhanden sind, die biologischen Prozesse jedoch nicht vollständig verstanden werden, kommen Techniken wie Partial Least Squares (PLS) und Hauptkomponentenanalyse (PCA) zum Einsatz. Diese Methoden analysieren mehrere miteinander verbundene Variablen - wie Temperatur, pH-Werte, gelöster Sauerstoff, Rührgeschwindigkeiten und Spektroskopiedaten - und destillieren sie in einige wenige Schlüsselmustern, die das normale Prozessverhalten repräsentieren.

Zum Beispiel etabliert PCA eine Basislinie mit Daten aus erfolgreichen Chargen. Wenn eine neue Charge von dieser Basislinie abweicht, können Statistiken wie Hotelling's T² potenzielle Probleme frühzeitig kennzeichnen, sodass Betreiber eingreifen können, bevor Probleme eskalieren. PLS geht noch einen Schritt weiter, indem es Echtzeitvorhersagen von Nährstoff- und Metabolitenspiegeln ermöglicht.Anstatt auf Offline-Assays zu warten, können PLS-Modelle Ereignisse wie Glukoseabbau oder Laktatansammlung vorhersagen, was es erleichtert, Fütterungspläne proaktiv anzupassen.

Ein weiteres wertvolles Werkzeug, SIMCA, füllt fehlende Daten mithilfe historischer Aufzeichnungen aus und stellt sicher, dass Lücken in Datensätzen die Fehlersuche nicht behindern. Der Erfolg dieser Modelle hängt jedoch davon ab, dass sie mit vielfältigen Datensätzen trainiert werden, die die Variabilität über Zelllinien, Medientypen und Produktionsmaßstäbe hinweg widerspiegeln. Dies stellt sicher, dass Betreiber Abweichungen während der Produktion von kultiviertem Fleisch schnell erkennen und beheben können.

Mechanistische und Hybride Modelle

Wenn ein solides Verständnis der zugrunde liegenden Physik und Biologie besteht, werden mechanistische Modelle - basierend auf Prinzipien wie Massenbilanzen und Transportgleichungen - unverzichtbar. Diese Modelle simulieren Schlüsselparameter wie Sauerstoffübertragung, Mischdynamik und Nährstoffverteilung innerhalb von Bioreaktoren. Sie sind besonders nützlich während der Hochskalierung, wo direkte Experimente kostspielig und zeitaufwendig sind.

In der Produktion von kultiviertem Fleisch können mechanistische Modelle auch vorhersagen, wie Scherkräfte Zellen beeinflussen, die an Mikrokugeln oder Gerüsten haften. Durch die Integration von hydrodynamischen Berechnungen mit Daten zur Zellensensitivität bieten diese Modelle Einblicke, wie Änderungen in der Agitation oder Perfusion die Zellviabilität und Gewebequalität beeinflussen könnten. Solche Vorhersagen sind entscheidend, um Leistungseinbrüche beim Übergang zu neuen Geräten oder bei der Hochskalierung der Produktion zu adressieren.

Hybride Modelle kombinieren die Stärken von mechanistischen und datengetriebenen Ansätzen. Sie verwenden einen mechanistischen Rahmen für physikalische Konsistenz, während sie datengetriebene Komponenten - wie neuronale Netze oder PLS - hinzufügen, um komplexe Kinetiken zu berücksichtigen, die nicht vollständig verstanden sind. Dies ist besonders relevant für kultiviertes Fleisch, wo das Wissen über Zelldifferenzierung in 3D-Gerüsten noch in der Entwicklung ist. Der mechanistische Teil sorgt für zuverlässige Vorhersagen unter sich ändernden Bedingungen, während die datengesteuerte Schicht sich an das Verhalten realer Anlagen anpasst. Diese hybriden Modelle ebnen den Weg für ausgeklügelte digitale Werkzeuge, die im nächsten Abschnitt besprochen werden.

Maschinelles Lernen und Digitale Zwillinge

Neuronale Netze sind hervorragend darin, nichtlineare Beziehungen zwischen Sensordaten und Ergebnissen wie lebensfähiger Zelldichte oder Differenzierungsmarkern zu identifizieren. Durch das Training dieser Modelle mit historischen Daten können sie als Frühwarnsysteme fungieren, die Anomalien erkennen, bevor sie sich zu bedeutenden Problemen entwickeln.

Modellprädiktive Regelung (MPC) geht einen Schritt weiter, indem sie prädiktive Modelle in Optimierungsprozesse einbettet.MPC ermöglicht Echtzeitanpassungen der Sollwerte, und Studien haben gezeigt, dass es die endgültigen Proteinausbeuten und die Produktqualität verbessern kann [8] .

Digitale Zwillinge - virtuelle Replikate physischer Bioreaktoren - kombinieren diese Modellierungstechniken, um Prozesse virtuell zu simulieren und zu beheben. Sie ermöglichen es den Betreibern, "Was-wäre-wenn"-Szenarien zu testen und Korrekturmaßnahmen in einer risikofreien Umgebung zu bewerten, bevor reale Änderungen vorgenommen werden. Da die Produktionsprozesse für kultiviertes Fleisch standardisierter und die Ausrüstung einheitlicher werden, wird erwartet, dass digitale Zwillinge eine zunehmend wichtige Rolle bei der routinemäßigen Fehlersuche und Prozessoptimierung spielen.

sbb-itb-ffee270

Fallstudien: Anwendungen der prädiktiven Modellierung

Beispiele aus der industriellen Zellkultur zeigen, wie prädiktive Modellierung spezifische Herausforderungen in Bioprozessen angehen und wertvolle Einblicke für die Produktion von kultiviertem Fleisch bieten kann.

Nährstoffabbau und Metabolitakkumulation

Das effektive Management von Nährstoffen ist in der Bioprozessierung entscheidend. Eine Studie aus einer Zellkulturanlage entwickelte ein prädiktives Modell, das multiple lineare Regression mit maschinellem Lernen kombinierte. Dieses Modell wurde entwickelt, um wichtige Ergebnisse wie den Endtiter, die maximale lebensfähige Zelldichte, Laktat- und Ammoniakspiegel früh im Produktionsprozess vorherzusagen. Beeindruckenderweise berücksichtigte es 70–95 % der Parametervariabilität. Durch die Identifizierung von gefährdeten Chargen Tage vor den herkömmlichen Alarmen ermöglichte das Modell gezielte Interventionen, verbesserte die Leistung und reduzierte die Variabilität [11].

In einem anderen Fall, der fed-batch Prozesse betraf, erreichten prädiktive Fütterungsstrategien basierend auf PLS (Partial Least Squares) multivariaten Modellen eine 30%ige Reduzierung der Laktatakkumulation. Diese Verbesserung führte zu einem 20%igen Anstieg der Endtiter [3].Wenn in Kombination mit Werkzeugen wie der Raman-Spektroskopie (e.g., in Sartorius ambr Bioreaktoren) eingesetzt, lieferte die Echtzeitüberwachung von Glukose, lebensfähiger Zelldichte und Metaboliten Vorhersagefehler von weniger als 5% [2][3]. Diese Ansätze könnten für die Produktion von kultiviertem Fleisch angepasst werden, wo ein präzises Nährstoffmanagement entscheidend für die Optimierung des Ertrags und die Kontrolle der Kosten ist.

Sauerstoffbegrenzung und Mischprobleme

Die Aufrechterhaltung angemessener Sauerstoffniveaus und einer ordnungsgemäßen Durchmischung ist eine weitere kritische Herausforderung in der Bioprozessierung. Modelle der numerischen Strömungsmechanik (CFD) werden häufig verwendet, um Sauerstoffgradienten und Mischmuster in Bioreaktoren zu simulieren. Während des Scale-ups haben diese Simulationen ineffiziente Rührerdesigns identifiziert, die hypoxische Zonen in Zellkulturen erzeugen. Durch die Anpassung der Rührgeschwindigkeiten basierend auf CFD-Ergebnissen verbesserte sich die Sauerstoffübertragungseffizienz um 20–30%.Einige Studien berichteten von Unterschieden im gelösten Sauerstoff von über 20–30 % zwischen verschiedenen Zonen in großen Reaktoren [2][7][9].

Zusätzlich setzte ein Biologika-Hersteller ein modellprädiktives Steuerungsframework (MPC) ein, das von digitalen Zwillingsmodellen unterstützt wird. Dies ermöglichte dynamische Anpassungen der Gasbegasung, löste effektiv Mischprobleme und erhöhte die Ausbeuten um 15 % [3][6]. Für die Produktion von kultiviertem Fleisch, bei der eine gleichmäßige Durchmischung entscheidend ist, um Nährstoffgradienten in Hochdichtekulturen zu vermeiden, bieten diese Strategien erhebliches Potenzial, um eine konsistente Gewebequalität sicherzustellen.

Schubspannung und Zellviabilität

Die durch Rührerbewegung und Kollisionen in gerührten Systemen verursachte Schubspannung kann die Zellviabilität erheblich beeinflussen.Prädiktive Modelle wurden verwendet, um diese mechanischen Kräfte und ihre Auswirkungen zu quantifizieren. In Mikrokulturträgerkulturen wurden Stressschwellen identifiziert, wobei Kräfte über 0,1 Pa mit einer Reduzierung der Lebensfähigkeit um 15–20 % für anhaftungsabhängige Zellen verbunden sind [2][10]. Durch die Optimierung von Perlengrößen und Rührgeschwindigkeiten führten modellgeführte Anpassungen zu einer Reduzierung des scherinduzierten Zelltods um 25 %, was zu über 2 % höheren Proteinausbeuten und besserer Produktqualität führte [2][8][10].

Während direkte Anwendungen in kultiviertem Fleisch noch in der Entwicklung sind, wurden ähnliche Hybridmodelle vorgeschlagen, um die Dynamik von Mikrokulturträgern zu simulieren. Diese könnten helfen, die Zelllebensfähigkeit während der Expansion über 90 % zu halten [6]. Diese Beispiele zeigen, wie prädiktive Modellierung nicht nur bestehende Herausforderungen adressiert, sondern auch proaktive Optimierung ermöglicht und den Weg für verbesserte Ergebnisse in der Produktion von kultiviertem Fleisch ebnet.

Zukünftige Richtungen und Implementierungsüberlegungen

Aufbauend auf erfolgreichen Fallstudien müssen zukünftige Strategien in der Produktion von kultiviertem Fleisch den Fokus auf die Implementierung fortschrittlicher Modelle neben modernster Ausrüstung und die Einhaltung standardisierter Protokolle legen.

Wichtige Erkenntnisse für Produzenten von kultiviertem Fleisch

Damit prädiktive Modellierung effektiv ist, sind drei kritische Komponenten erforderlich. Erstens spielen integrierte Sensoren eine entscheidende Rolle bei der gleichzeitigen Analyse wesentlicher Parameter und gewährleisten die Effizienz des Modells in Echtzeit.Zum Beispiel können Raman-Spektroskopie-Plattformen Glukosespiegel, lebensfähige Zelldichte und Metaboliten gleichzeitig überwachen, was präzise Feedback-Kontrollstrategien ermöglicht [2] [5]. Diese integrierten Plattformen vereinfachen die Echtzeitüberwachung, optimieren Prozesse und reduzieren Abfall erheblich [2].

Zweitens ermöglicht die Scale-Down-Experimentation die Entwicklung robuster Modelle im kleineren Maßstab, bevor sie auf kommerzielle Bioreaktoren angewendet werden. Diese Modelle müssen hohe Präzision beibehalten, Rauschen effektiv handhaben und erfordern bei der Hochskalierung nur minimale Neukalibrierung [2] . Analogien aus der Zell- und Gentherapie - Bereiche mit ähnlichen Herausforderungen - zeigen, dass Scale-Down-Daten durch Produktionsläufe im großen Maßstab validiert werden müssen, um Zuverlässigkeitsprobleme zu adressieren und nahtloses Skalieren zu gewährleisten [2].Zuletzt sind standardisierte Datenprotokolle, die mit den ISA-88-Standards übereinstimmen, unerlässlich. Diese Protokolle ermöglichen Echtzeit-Freigabetests und adaptive modellprädiktive Steuerung (MPC), wodurch prädiktive Modelle zu präskriptiven Analytik-Tools weiterentwickelt werden [2] [3]. Zusammen adressieren diese Strategien aktuelle Herausforderungen und eröffnen neue Fortschritte.

Forschungslücken und -möglichkeiten

Trotz Fortschritten bestehen weiterhin mehrere Herausforderungen. Ein großes Problem ist der Mangel an offenen Datensätzen, was die Entwicklung robuster, anpassungsfähiger Modelle für den Einsatz in verschiedenen Bioreaktortypen und -größen behindert [2][3][4].Ein weiteres Problem ist die Modellübertragbarkeit - viele Modelle versagen bei der konsistenten Leistung, wenn sie von Laborumgebungen in Produktionsumgebungen übergehen oder auf unterschiedliche Gerätekonfigurationen angewendet werden [2] [3][4]. Darüber hinaus besteht eine schwache Verbindung zwischen Modellvorhersagen und den endgültigen Produktqualitätsmerkmalen, wie Zellviabilität und Gesamtertrag [2][3][4].

Um diese Hürden zu überwinden, sind standardisierte Protokolle und gemeinsame Datensätze erforderlich, um die Anpassungsfähigkeit der Modelle zu verbessern. KI-gesteuerte Hochskalierungssimulationen könnten helfen, das Verhalten in größeren Maßstäben vorherzusagen und die Übertragbarkeit zu verbessern [4][10].Hybride Modelle, die datengetriebene Ansätze mit mechanistischen Erkenntnissen kombinieren, bieten ungenutztes Potenzial für das Management biologischer Variabilität [6]. Die Stärkung der Verbindung zwischen Modellvorhersagen und Qualitätsmerkmalen durch fortschrittliche MPC und Sensitivitätsanalyse könnte geschlossene Regelkreissysteme und virtuelle Tests für Prozessanpassungen ermöglichen [3][6].

Die Behebung dieser Lücken erfordert Investitionen in Geräte, die für Skalierbarkeit und Präzision ausgelegt sind.

Überlegungen zu Ausrüstung und Beschaffung

Für den Erfolg der prädiktiven Modellierung ist spezialisierte Ausrüstung erforderlich, die in der Lage ist, datenreiche Umgebungen zu schaffen.Produzenten sollten evaluieren, ob ihre Ausrüstung integrierte Sensoren - wie Raman-Spektroskopiegeräte - unterstützt und ob sie effektiv skalieren kann, während sie automatisierte Steuerungen wie MPC [2][3] aufnehmen kann. Zuverlässige Überwachung kritischer Prozessparameter ist ein Muss, damit prädiktive Modelle optimal funktionieren.

Eine Ressource wie

FAQs

Wie unterstützt prädiktive Modellierung die Produktion von kultiviertem Fleisch?

Prädiktive Modellierung spielt eine Schlüsselrolle bei der Verbesserung der Produktion von kultiviertem Fleisch, indem sie potenzielle Herausforderungen im Bioprozess frühzeitig erkennt und angeht, bevor sie zu größeren Problemen werden. Dieser vorausschauende Ansatz hilft, Ausfallzeiten zu reduzieren, die Effizienz zu verbessern und eine gleichbleibende Produktqualität zu gewährleisten.

Durch die Untersuchung von Daten aus Bioprozesssystemen können diese Modelle Muster aufdecken und Probleme vorhersehen, sodass Forscher und Produktionsteams fundierte Anpassungen vornehmen können. Das Ergebnis? Höhere Erträge, weniger Abfall und niedrigere Betriebskosten - alles trägt zu einem nachhaltigeren und zuverlässigeren Produktionsprozess von kultiviertem Fleisch bei.

Welche Daten sind entscheidend für effektives prädiktives Modellieren bei der Fehlersuche in Bioprozessen?

Genaue und detaillierte Daten sind das Rückgrat des effektiven prädiktiven Modellierens bei der Fehlersuche in Bioprozessen. Die wichtigsten Faktoren, die überwacht werden müssen, sind Temperatur, pH-Werte, gelöster Sauerstoff, CO₂-Konzentrationen, Glukosewerte, Biomassemessungen und Metabolitprofile.

Die Erfassung von qualitativ hochwertigen Echtzeitdaten zu diesen Variablen ist entscheidend. Sie ermöglicht es Forschern und Fachleuten der Industrie, potenzielle Probleme frühzeitig zu erkennen, um einen reibungslosen Betrieb zu gewährleisten und die Gesamtleistung des Bioprozesses zu optimieren. Dieser proaktive Ansatz hilft, Ausfälle zu minimieren und die Prozesse effizient am Laufen zu halten.

Wie verbessern Hybridmodelle die Fehlersuche in kultivierten Fleischbioprozessen?

Hybridmodelle transformieren die Fehlersuche in kultivierten Fleischbioprozessen, indem sie mechanistische Modelle mit datengetriebenen Methoden kombinieren. Diese Kombination schafft ein leistungsstarkes Werkzeug, um genaue Vorhersagen über potenzielle Probleme zu treffen und kritische Prozesse zu optimieren.

Mit der Fähigkeit, Systeme in Echtzeit zu überwachen und Probleme frühzeitig zu erkennen, reduzieren Hybridmodelle Unterbrechungen und verbessern das Prozessmanagement. Das Ergebnis? Größere Effizienz, höhere Erträge und zuverlässigere Produktionssysteme.